Ứng dụng hữu ích giúp các tín đồ nghiện video có thể xem YouTube đã đời mà vẫn nhai Snack Khoai Tây đã thèm.

YouTube đang ngày càng thịnh hành khi người người xem video, nhà nhà mở YouTube, nhất là từ khoảng thời gian "cô Vy ghé chơi", chẳng ai muốn ra ngoài. Tất nhiên, xem video trên YouTube làm sao thiếu những gói Snack Khoai Tây thơm ngon, tròn vị đồng hành. Tuy nhiên tiếng Snack Khoai Tây giòn rụm khi nhai khiến bạn không nghe rõ lời thoại từ video lắm lúc gây khó chịu. Vậy là Lay’s liền giới thiệu đến hội ghiền phim, say đắm tiếng giòn ngon của Snack Khoai Tây ứng dụng Lay's Crispy Subtitles – plugin đầu tiên chuyển đổi tiếng giòn tan thành phụ đề!

Ăn Snack Khoai Tây giòn ngon đã thèm mà vẫn có thể xem video đã đời

Đây chính là thành quả hợp tác giữa Lay’s, Happiness Saigon và BLISS. Họ tạo ra "Lay’s Crispy Subtitles" thông qua việc sử dụng thuật toán máy học chạy trực tiếp trên plugin của trình duyệt. Bài viết này sẽ giúp bạn hiểu cách plugin hoạt động như thế nào.

Thu thập dữ liệu

Để dạy âm thanh giòn cho máy học, bộ sưu tập gồm 17.512 mẫu âm thanh "giòn rụm" khác nhau đã được thử nghiệm. Điều này cũng đồng nghĩa rất nhiều Snack Khoai Tây đã "hao tốn" trong quá trình phát triển plugin.

Tiền xử lý

Lúc này, các âm thanh được chuẩn bị sẵn sàng cho việc xử lý. Để đảm bảo plugin chạy được hoàn toàn ở phía người dùng trên trình duyệt sử dụng Tensorflow JS, các mẫu sử dụng phải tuân thủ các điều kiện và quy trình khắt khe:

● Âm thanh đơn âm 22.050 KHz, có thể chuyển đổi nếu cần.

● Sử dụng librosa trong Python để trích xuất các mẫu âm thanh để xác thực hoặc loại bỏ.

● Tiếp đến, các hệ tần số Mel được tạo ra để chuyển dữ liệu thô thành thông tin nhận thức và giảm kích thước dữ liệu. Cuối cùng, dùng Meyda để trích xuất dữ liệu.

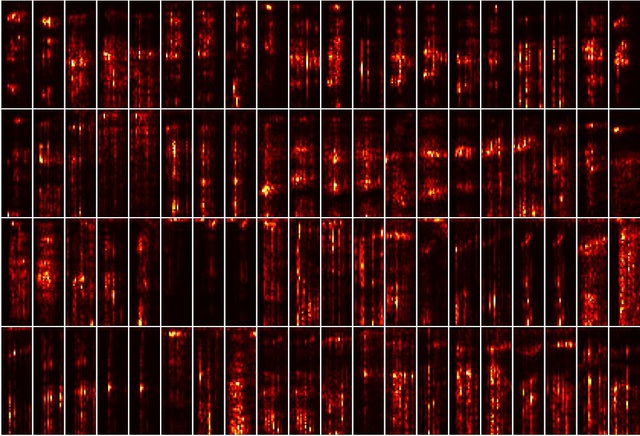

Sau các bước kể trên, Lay's Crispy Subtitles có được thông tin quang phổ sau:

Đây là dữ liệu đầu vào của mô hình mà sau đó được sử dụng để đánh giá xem liệu một mẫu 232 mili giây có thể được coi là một tiếng "giòn rụm" hay không.

Hình thành mô hình

Tiếp theo, dùng Keras và Tensorflow để thiết lập mô hình máy học phân loại âm thanh. Trước tiên, tập dữ liệu được phân loại theo nhãn tích cực và tiêu cực, tạo nên tập hợp thử nghiệm và đào tạo bằng sklearn.

Sau rất nhiều thử nghiệm, mô hình phân lớp bao gồm 2 lớp Conv2D Maxpooling2D, một lớp Dense (128) với kích hoạt relu và một lớp Dense (2) với kích hoạt softmax được lựa chọn. Những âm thanh bị loại được thêm vào giữa mỗi lớp để tránh bị quá khớp.

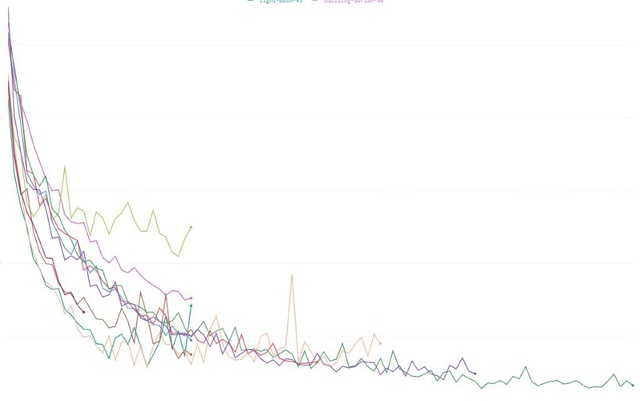

Huấn luyện

Cross entropy phân loại để tính toán tổn thất và sử dụng trình tối ưu hóa Adam để đào tạo mô hình với kích thước lô là 64 trong 75 epochs. Sau cùng, mô hình có độ không chính xác là 0,0831 và độ chính xác là 0,986.

Thiết lập plugin và tích hợp mô hình

Quá trình này được thực hiện trong hệ sinh thái Python. Sau đó, chúng được chuyển đổi bằng Tensorflow JS và cuối cùng chỉ còn kích thước dưới 5MB và được tích hợp trong plugin. Khi kích hoạt plugin, phụ đề sẽ xuất hiện. Trong trường hợp video có phụ đề nhưng bị tắt thì máy học cũng sẽ nhận diện và tự động bật phụ đề lên sau 10s.

Đây quả là một "chiếc phao cứu tinh" đến từ Lay's dành cho hội vừa ghiền xem video trên YouTube, vừa ghiền nhai rồm rộp Snack Khoai Tây trong lúc xem.

Giờ thì hãy thử nghiệm tính hiệu quả của Lay's Crispy Subtitles bằng cách tải miễn phí từ Chrome Webstore tại http://bit.ly/LaysCrispySubtitles, cài đặt plugin vào máy, mở YouTube và vừa xem video đã đời vừa nhai Snack Khoai Tây Lay's đã thèm.

NỔI BẬT TRANG CHỦ

Huawei và SMIC gặp khó khăn với tiến trình sản xuất chip, mắc kẹt ở 7nm cho đến ít nhất năm 2026

Huawei và SMIC sẽ phải đối mặt với hàng loạt khó khăn trong thời gian tới.

Dựa trên lý thuyết mới, lần đầu tiên ngành vật lý học "chụp hình" được một hạt photon